Super Resolution vs. Reality Creation

vs.Darbee Darblet

Die Scharfmacher… Dritter Teil!

Großes Update unseres Specials...

Der Zweck der Einführung der „FullHD“ Auflösung vor wenigen Jahren klärt schon der Name selbst: In direkter wörtlicher Übersetzung bedeutet „High Definition“ nichts anderers als „hohe Bildschärfe“. Und tatsächlich, mit rund der vierfachen Auflösung gegenüber herkömmlichem PAL (Standard Definition) brachte HDTV einen für jedermann ersichtlichen grandiosen Qualitätssprung in Sachen Detaildarstellung.

Und dennoch ist das Optimum noch nicht erreicht, die gesunde Sehschärfe vor allem bei der Großbildprojektion noch nicht ausgereizt: Die Hersteller arbeiten fleißig an der „Ultra HD“ Auflösung, bei Fernsehern ist sie bereits nahezu Standard, allein die Softwareindustrie hinkt nach.

Apropos Softwareindustrie: Viele Großbildfans beklagen zurecht, dass nicht die FullHD Auflösung alleine denn limitierende Schärfefaktor ausmacht, sondern viele Filme auf Bluray oder TV-Übertragungen das volle Auflösungspotenzial gar nicht nutzen, sondern zu Gunsten einer schmaleren Bandbreite Verluste in Kauf nehmen. Tatsächlich wird die maximalmögliche Bildqualität von FullHD in der Praxis nur selten erreicht. FullHD „geht also noch besser“.

Dieses Potenzial hat auch die Unterhaltungselektronik-Industrie erkannt und bietet seit Jahren intelligente Signalprozessoren zur nachträglichen Bildaufbereitung von FullHD Quellen an, zunächst als externe Scaler, seit geraumer Zeit als „kostenlose Zugabe“ in hochwertigen TVs oder Projektoren. Jeder Hersteller gibt seiner Technologie dabei webwirksame Marketing-Namen: Super Resolution, Reality Creation, Detail Clarity usw. usw.

Prinzipiell haben die Algorithmen die Aufgabe, Konturen schärfer abzugrenzen, Auflösung zu ergänzen und Kontraste zu verstärken, denn dies sind alles Bildaspekte, die von unseren Augen subjektiv als mehr Schärfe interpretiert werden. Doch bergen sie auch die Gefahren der digitalen Verfremdung und Überschärfung.

In diesem Special vergleichen wir drei der derzeit bekanntesten Systemen am Markt unter praxisnahen Bedingungen: Die „Super Resolution“ des Epson EH-TW9200, die „Reality Creation des Sony VPL-HW55 und, als externe Lösung für alle anderen Projektoren, der „Darblet“ Prozessor aus dem Hause Darbee. Welcher Bildverbesserungen bewirken die einzelnen Systeme, welche Nebenwirkungen haben sie, welches System überzeugt am meisten und sind derartige Systeme überhaupt zu empfehlen? All diese Fragen beantworten wir auf den folgenden Seiten…

Austragungsort unseres Vergleichs war das renommierte Beamer-Fachgechäft „Heimkino-Boutique“: Inhaber Gunnar Witting hat hier alle Modelle stets vorführbereit und kann unter optimalen Heimkino-Bedingungen den hier vorgestellten Vergleich jederzeit persönlich demonstrieren, ein Besuch lohnt also!

1. Funktionsweise und etwaige Nebenwirkungen

Bevor wir vergleichen, möchten wir vorab die technischen Grundlagen erläutern, wie genau kann die Schärfe eines Videobildes ohne native Auflösungserhöhung gesteigert werden?

1.1 Mehr Schärfe durch Manipulation der Helligkeit?

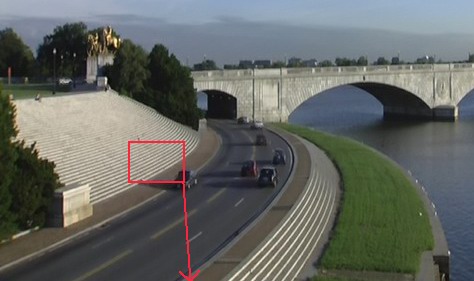

Um das Prinzip der Schärfeanhebung zu erklären, bedienen wir uns eines bekannten Beispiels. Als Ausgangsbasis betrachten wir ein Bild mit verschieden detaillierten Elementen, es handelt sich um die bekannte Brücke der HQV-Testdisc:

Original-Bild,

wie es auf der Signalquelle abgelegt ist

Das Panorama wirkt detailliert und glaubwürdig, doch es birgt Schärfepotenzial, das folgende nachbearbeitete Variante zeigt:

Digital nachgeschärft

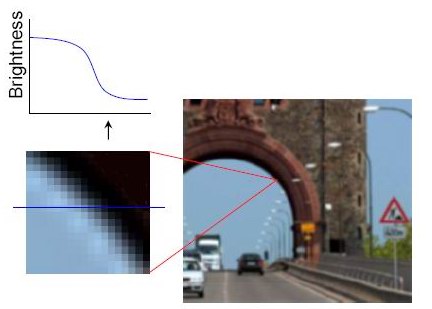

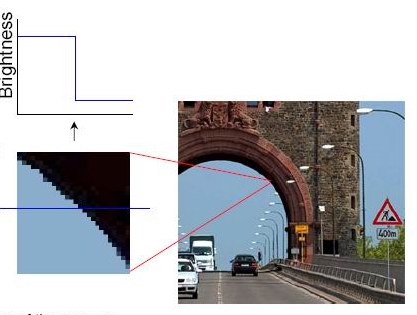

Obwohl es sich um genau denselben Bildinhalt mit derselben Auflösung handelt, wirkt diese nachbearbeitete Version wesentlich schärfer. Wieso das so ist, zeigt sich schnell, wenn wir kleine Details gezielt vergrößern. Betrachten wir z.B. die Treppenstufen links "unter der Lupe", zunächst in der weicheren Ursprungsversion:

In der Vergrößerung sehen die Stufen wie schräge Hellgrau -> Dunkelgrau -> Hellgrau Balken aus. Jede Stufe ist deutlich abgegrenzt, doch über dem Bild hängt eine Art Schleier. Nun betrachten wir die "nachgeschärften" Stufen in der Detailaufnahme:

Bei genauer Betrachtung fällt auf, dass die Stufen in ihrer Dynamik gespreizt wurden. Das bedeutet, dass die dunklen Zwischenräume abgedunkelt wurden (dunkleres Grau), während die hellen Stufen aufgehellt wurden (helleres Grau). Dadurch wird der Kontrast zwischen den Details erhöht, die Trennung verstärkt, das Bild wirkt subjektiv schärfer.

Doch es fallen auch erste Nebeneffekte auf: Die härteren Kontrastübergänge betonen auch die Treppenbildung stärker, die Vergrößerung wird pixeliger und anfälliger für Artefakte. Bei FullHD-Projektoren ist die native Auflösung zum Glück aber so hoch, dass derartige pixelkleine "Aliasing"-Effekte nicht sehr groß ins Gewicht fallen. Dennoch verbirgt sich hier ein störender Nebeneffekt, der im Übermaß unbedingt vermieden werden sollte. Im nächsten Beispiel erhöhen wir die nachträgliche Schärfe noch weiter, um eine weitere Gefahr aufzuzeigen:

Jetzt werden die hellen und dunklen Elemente noch weiter zueinander gespreizt und die Treppe wirkt folgerichtig noch schärfer. Doch es fällt auf, dass die hellen Stufen teilweise nun schon den Maximalpegel (Weiß) erreicht haben, der Gelb / Beige Charakter des Originals ist fast vollständig verloren, die Stufen wirken blasser und überbelichtet, nahezu künstlich.

1.2 Mögliche Artefaktbildung / Anforderungen an einen Schärfealgorithmus

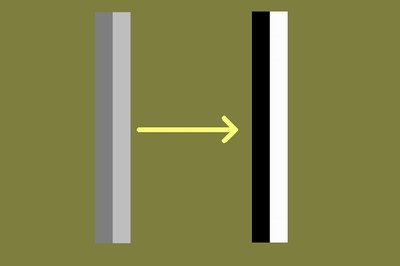

Nun wissen wir, dass es sich bei der nachträglichen Schärfeanhebung um eine Art "Pixelbasierende Gammakorrektur" handelt: Befindet sich im Bild ein helleres Element neben einem dunkleren, so wird der Kontrast durch Spreizen (Aufhellen + Abdunkeln) erhöht, damit die Trennung stärker herausgearbeitet wird, was von unserem Auge als "schärfer" interpretiert wird.

Pixelübergänge werden im Kontrast erhöht, der Schärfeeindruck so verstärkt

Man erkennt, dass nicht wirklich Details hinzugefügt werden (woher auch, wenn sie nicht im Bildsignal enthalten sind?), sondern die vorhandenen Details lediglich stärker betont werden. Dies ist eine einfache wie effektive Methode, zumindest in der Theorie, denn es bergen sich diverse Gefahren:

1.2.1 Überbelichtung

Den ersten Nebeneffekt haben wir oben bereits erarbeitet: Spreizt man den pixelbasierenden Kontrastumfang zu sehr, erreicht man schnell den weißen Bereich, das Bild wirkt künstlich, überbelichtet und blass.

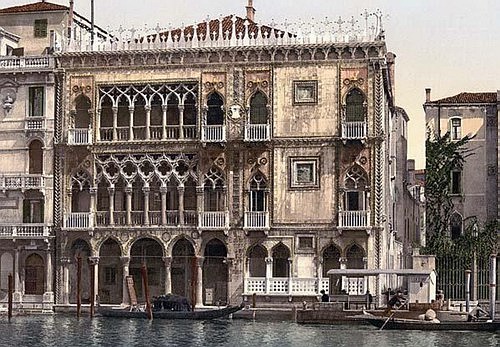

Bei diesem Beispielbild sind die Überbelichtungen besonders gut an den Fensterrahmen und Säulen zu erkennen. Sie sind im Original (oben) schon sehr hell und werden durch die pixelbasierende Kontrastanhebung in den weißen Clipping-Bereich verschoben:

Im Ergebnis (oben) wirkt das Foto beinahe schon reliefartig verfremdet. Übertreibt man es mit der Schärfeanhebung, leiden auch bunte Elemente, wie das folgende Beispiel zeigt:

Oben: Original, unten: Überschärft

Auch hier haben wir es mit Übersteuerungen zu tun, die sich wie weißer Staub in alle Details zu legen scheint. Auf derartige Artefakte ist bei der Beurteilung von Schärfealgorithmen unbedingt zu achten.

1.2.2. Aliasing

Aliasing ist der englische Fachbegriff für auflösungsbedingte Treppenstufen. Vor allem Computerspielfans werden die sogenannte "Anti-Aliasing"-Filter kennen, die dafür sorgen, dass feine diagonale Linien und Elemente im Bild nicht ausgefranst, sondern natürlich aussehen. Auch eine Schärfeanhebung kann als unangenehmen Nebeneffekt Aliasing verursachen. Dazu betrachten wir folgendes Bild, wie es in jedem Spielfilm vorkommen könnte:

Im Vordergrund befindet sich eine Stadtstraße mit typisch vielen Markierungen. Im Original oben wirken diese Markierungen glaubwürdig, obwohl die Auflösung mit den schrägen weißen Diagonalen bereits an ihre Grenzen kommt. Doch eine gewisse Weichzeichnung verhindert starke Treppenstufen. Schärfen wir diese Weichzeichnung weg, sieht es folgendermaßen aus:

Sicherlich ist der Bildeindruck nun ein deutlich schärferer, doch durch die Kontrastanhebung der Straßenmarkierungen wirken diese nun unnatürlich ausgefranst und digital gerastert. In Bewegung (z.B. durch einen Kameraschwenk) werden solche Artefakte weiter verstärkt, so dass Zeilenflimmern die Folge sein können. Eine intelligente Schärfeanhebung sollte Aliasingartefakte vermeiden.

1.2.3 Verstärktes Rauschen

Jeder kennt den Effekt aus der Fotografie oder hat ihn schon oft bei Filmen im (Heim-)Kino beobachten können: Homogene farbige oder graue Flächen erscheinen auf der Leinwand nicht wirklich einheitlich, sondern sind durch Tausende von kleinen Punkten gesprenkelt. Diese bewegen sich von Bild zu Bild, es entsteht ein visuelles Rauschen, von Laien oft als "Grieseln" bezeichnet. Hierbei handelt es sich also nicht um ein Digital-Artefakt der Beamer, sondern um ein Artefakt des analogen Zelluloid-Mediums.

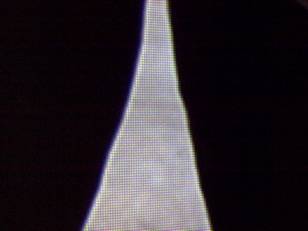

Beim Rauschen scheiden sich die Geister, wie sich bei der Einführung der Blu-ray und verschiedenen Pack-Algorithmen zeigte: Die "konservative" Seite unter den Filmemachern und Studios vertritt die Meinung, dass es sich beim sichtbaren "Filmkorn" um ein erhaltenswertes Artefakt handelt, das beim Mastering nicht geglättet werden sollte. Andere wiederum bevorzugen den glatteren und natürlichen "bereinigten" Look. Wie dem auch sei, bis heute zeigen die meisten DVDs und Blu-rays ein sichtbares Filmrauschen. Betrachten wir dieses in einem Einzelbild in der Vergrößerung:

Einfarbige Flächen sind aus der Nähe verrauscht

Die vermeintlich einheitliche Fläche erscheint bei genauer Betrachtung gesprenkelt, viele dunkle und helle Flecken und Punkte streuen um die "Sollfarbe". Diese bewegen sich von Einzelbild zu Einzelbild, wodurch ein gleichmäßiges Rauschen entsteht.

Wie bereits erläutert, wird die Bildschärfe durch eine Kontraststeigerung zwischen den Pixeln erreicht. Für unsere "verrauschte" Fläche heißt das, dass der Kontrast zwischen der Sprenkelung erhöht wird, die dunkleren Flecken / Pixel werden abgedunkelt, die hellen weiter erhellt. Als Ergebnis wird das Rauschen deutlich ausgeprägter:

Eine Schärfeanhebung verstärkt das Rauschen

Ein Schärfealgorithmus sollte daher entweder solche Rauschflächen erkennen, oder so moderat arbeiten, dass das Rauschen nicht signifikant gesteigert wird, sicherlich keine einfache Aufgabe.

1.2.4 Doppelkonturen

Besonders herkömmliche Schärfeeinstellungen von Fernsehern oder Projektoren sind für diese Artefakte bekannt: Erhöht man den Schärferegler zu sehr, stellen sich schnell unschöne Doppelkonturen im Bild ein, auch "Ringing" genannt.

Solche Konturen entstehen vor allem neben starken Kontrastübergängen von Hell nach Dunkel oder umgekehrt. Besonders bei Gegenlichtaufnahmen werden sie vor dem Himmelhintergrund sehr deutlich (siehe Beispiel oben).

Eine leistungsfähige, moderne Schärfeanhebung sollte keine solchen Doppelkonturen erzeugen, das ist selbstverständlich. Und dennoch ergibt sich ein Problem: Nicht selten weist das Bildmaterial oder die Signalquelle bereits ein minimales Ringing auf: Kaum sichtbare Doppelkonturen um scharf abgegrenzte Objekte. Bei herkömmlicher Schärfe fallen diese nicht auf, doch eine nachträgliche Schärfeerhöhung hebt ja pixelbasierend den Kontrast an und wie beim Rauschen wird dieses Artefakt dann richtig deutlich.

Die Schärfeanhebung betont Doppelkonturen

Hier kommen wir in einen Bereich, der nur sehr schwer durch "Intelligenz der Schaltung" zu umgehen ist. Eine vollständige Objekterkennung ist nach wie vor nicht möglich.

1.2.5 Beabsichtigte Unschärfen

Pauschal die Schärfe in jedem Bild gleichmäßig anzuheben, ist nicht unbedingt der richtige Weg, denn schärfer ist nicht unbedingt auch besser. Ein besonderer Gesichtspunkt, der bei vielen Heimkinofans und "Schärfefanatikern" nicht berücksichtigt wird: Ein Kinobild soll (je nach Komposition) gar nicht in allen Bereichen scharf sein! Das klingt zunächst unverständlich, doch dabei sind Unschärfen das Natürlichste auf der Welt:

Unsere Augen sind in ihrer Funktion so aufgebaut, dass sie stets nur einen Abstandsbereich fokussieren können. Konzentriert man sich auf ein Objekt, so erscheint nur dieses (und andere Objekte mit gleichem Abstand) scharf, alles andere ist eher verschwommen und verliert daher in der Wahrnehmung auch an Beachtung / Bedeutung. Gleiches gilt für eine Fotokamera.

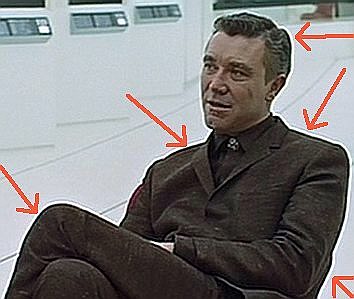

Und genau diese menschlichen Wahrnehmungseigenschaften machen sich gute Regisseure zu Nutze: Durch ein klares Abgrenzen der Fokusebene beeinflussen sie, worauf im Bild sich der Zuschauer konzentriert, welchen Elementen er größere Beachtung schenkt, als anderen. Dies ist zwingend notwendig, um den Blick der Zuschauer zu steuern, denn aufgrund der Zweidimensionalität des Bildes (die Leinwand ist flach und befindet sich stets nur auf einer Fokusebene des Auges), bleiben dem Gehirn keine anderen visuellen Anhaltspunkte für "wichtiges Bildgeschehen", als die Bildschärfe:

Original...

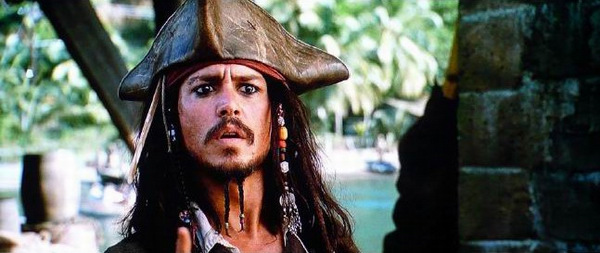

Bei obigem Beispielbild wird dies schnell deutlich: Der Protagonist (Johnny Depp) steht im Zentrum des Geschehens und wird daher scharf abgebildet, während der Hintergrund und die Mauer rechts unscharf und unbedeutend erscheinen. Durch die unterschiedlichen Schärfeebenen gewinnt das Bild signifikant an räumlicher Tiefe.

...herkömmlich nachgeschärft...

Schärft man das gesamte Bild nach herkömmlichen Methoden nach (Bild oben), so verliert es an dieser räumlichen Tiefe, Mauer und Protagonist sind auf gleicher Ebene, das Auge wird abgelenkt, das Bild wirkt flach. Noch deutlicher wird dies im folgenden Beispiel:

...durch falsche Schärfeanhebung verfremdet.

In diesem Beispiel ist die Mauer schärfer als der Schauspieler und tritt so räumlich in den Vordergrund, obwohl sie für das Geschehen von keinerlei Bedeutung ist.

Aus diesen wichtigen Aspekten heraus muss eine intelligente Schärfeanhebung daher zwischen der Fokusebene / wichtigen Elementen und "Nebenschauplätzen" unterscheiden. In obigem Bild macht es z.B. nur Sinn, das Gesicht Johnny Depps in der Schärfe anzuheben, nicht aber die Mauer oder den Hintergrund. Nur so bleibt die originale Bildkomposition erhalten und gewinnt sogar durch die gezielte Schärfeerhöhung zusätzlich an Tiefe:

Oben Original, unten gezielt in nur wichtigen

Bereichen geschärft

Die Bildtiefe steigt,

ohne dass die Komposition verfremdet wird

Dieses Beispiel macht deutlich, wie ein intelligent komplexer Schärfealgorithmus die Bildqualität sichtbar verbessern kann, ohne dabei die Bildkomposition zu stören. Der Schauspieler tritt noch deutlicher in den Vordergrund, Mauer und Hintergrund bleiben unberührt und "unbedeutend". Das Bild wirkt noch plastischer und ansprechender.

1.3 Anforderungen an einen Schärfealgorithmus

Unser Überblick der möglichen Probleme hat aufgezeigt, dass es gar nicht so einfach ist, die Schärfe des laufenden Filmbildes zu erhöhen. Schnell werden Artefakte provoziert (Aliasing, Übersteuerung), oder bereits vorhandene verstärkt (Rauschen, Doppelkonturen), oder die beabsichtigte Bildkomposition verfremdet (Fokusebenen), wenn man es übertreibt. Sind die beiden Schärfetechniken von Epson und Panasonic in der Lage, diese Aspekte alle zu berücksichtigen?

2

. Der Test: Praxisvergleich der einzelnen Systeme

Nachdem wir im letzten Kapitel die grundlegenden Funktionsweisen und die möglichen Nebenwirkungen kennen gelernt haben, wollen wir dieses Wissen auf die derzeit drei konkurrierenden Systeme anwenden. Dazu wählen wir zwei bekannte Filmkonstellationen und überprüfen die Merkmale der Bildanschärfung im Detail:

2.1 Epson Super Resolution

Bei den Projektoren ist Epson der Pionier der nachträglichen Schärfeanhebung. Der Klassiker auf dem Gebiet der Schärfealgorithmen ist daher die viel bekannte „Super Resolution“, die sich in den Spitzenmodellen des Marktführers Epson seit Jahren einer großen Beliebtheit erfreut.

Der NEC-Schärfemacher auf der Hauptplatine

Weitere Recherche auf Webseiten des Elektronikkonzerns NEC ergibt, dass es sich tatsächlich um einen Signalprozessor handelt, dessen Aufgabe die sichtbare Verbesserung der Bildschärfe ist. Er ist Teil der "Neo Clear Resolution" Familie. Und siehe da: "Single Frame Super Resolution" zeigt, dass auch der Name nicht von Epson, sondern aus dem Hause NEC stammt. Dies erklärt auch, dass die Super Resolution in immer mehr Projektoren / Fernsehern mittlerweile anzutreffen ist.

"Single Frame" bedeutet, dass die Bildanalyse stets auf einem Einzelbild basiert. Würde man auch nachfolgende Bilder bei der Berechnung mit berücksichtigen, könnte man zweifelsohne eine noch höhere Genauigkeit erreichen, doch überschreitet dies derzeit noch die möglichen Rechenleistungen.

Wir zeigen die Funktionsweise des Algorithmus in einem Flussdiagramm auf, das die einzelnen Arbeitsschritte und ihre Reihenfolge abbildet:

Funktionsweise der "Super Resolution"

Im ersten Schritt wird das eingehende Bild auf Unschärfen hin untersucht. An den Stellen, wo der Prozessor Schärfepotenzial erkennt, sollen durch die sogenannte "Mixed Color Separation" Technologie kleine Details schärfer abgegrenzt werden. Schon wieder ein englischer Funktionsname, was verbirgt sich dahinter? Skaliert man ein Bild auf eine höhere Auflösung (von PAL nach HD zum Beispiel), so werden Kanten oft weich gezeichnet, indem gemittelte Farbwerte als fehlende Pixel eingefügt werden:

Durch diese Skalierungsmethode wirkt das Ergebnis sehr natürlich und fein, doch die maximale Schärfe wird nicht erreicht. Hier setzt nun die Color-Separation ein: Der Algorithmus soll derartige Farb- / und Helligkeitsübergänge erkennen und entfernen, ohne dabei Formen und Strukturen zu verfälschen:

Im letzten Schritt wird das neu berechnete "Super Resolution"-Bild mit dem Original verglichen, noch einmal bearbeitet und verlässt schließlich die Signalleitung.

Damit sind wir schon bei dem Schwerpunkt der NEC-Super Resolution: Ursprünglich wurde sie dafür konstruiert, um aus herkömmlichem SD-Material (PAL / NTSC) nach der Skalierung mehr Schärfe zurückzugewinnen, doch auch bei HD-Material soll die Schaltung für mehr Schärfe sorgen, und zwar nach der pixelbasierenden Gamma-Methode, die wir bereits eingangs in diesem Special erklärt haben. Es zeigt sich aber ebenso, dass diese Schaltung bei einer Hochskalierung auf 4K wiederum sehr viel Potenzial mit sich bringt. Das Prinzip der Super Resolution ist Grundlage für alle weiterführenden Techniken, auch für die folgenden...

Soweit die Theorie, kommen wir nun zur Testpraxis. Dazu betrachten wir eine Szene aus „Batman“, die jeder Filmfan kennt. Die letzte ruhigen Sekunden, bevor der Joker zuschlägt…

Im obigen Screenshot sehen wir die Szene in ihrer nativen Bluray-Darstellung ohne nachträgliche Bildbearbeitung. Unsere Auswahl wirkt überraschen unspektakulär, denn diese Szene „schreit“ nicht unbedingt nach einer nachträglichen Schärfeanhebung. Dennoch birgt sie einiges Potenzial für Verbesserungen, aber auch Fallen, die die Qualitätsunterschiede der Algorithmen aufzeigen.

Betrachten wir zunächst die dunkle Hose des Jokers: Im Kontrast zur hellen Straße ist hier im Original kein signifikantes Schärfedefizit zu erkennen. In der Makroaufnahme erkennt man allerdings, dass der Protagonist sich keinesfalls „schwarz auf weiß“ von dem Hintergrund abhebt. Die Ränder sind mit Graustufen ein wenig weichgezeichnet, allerdings nicht ohne Grund: Die „Mikrograutreppen“ sorgen dafür, dass die limitierte FullHD-Auflösung nicht zu ersichtlich wird, sie vermindern Treppenstufen und oben erläuterte „Aliasing“-Artefakte, die das Bild künstlich digital erscheinen lassen würden. Hier wurde also mit „Anti Aliasing“ ein Kompromiss aus Detailschärfe und Natürlichkeit angewendet.

Doch perfekt ist dieses Mastering nicht, denn bei genaue Hinsehen wird eine leichte Doppelkontur neben den Beinen deutlich, hierbei handelt es sich um das so unschöne und ungewollte „Ringing“.

Wie behandelt Epsons „Super Resolution“ nun dieses Bilddetail? Die Intensität ihres Eingriffs lässt sich in 5 Stufen regeln. Wir haben jede Stufe fotografiert und das Ergebnis spricht eine eigene Sprache:

Stufe1…

…2…

…3…

…4…

…5…

Tatsächlich, die subjektive Schärfe wird hier gravierend erhöht und der Algorithmus arbeitet genau so, wie vom Hersteller, doch über einen Gewinn der Bildqualität lässt sich streiten.

Auf der einen Seite entfernt die Super Resolution konsequent alle „Weichzeichnungs-Graustufen“ und erhöht so den Kontrast zwischen Objekt und Hintergrund, die subjektive Schärfe wird dadurch erhöht. Doch leider werden die schrägen Kanten sehr „ausgefranst“, die so ungewollten Aliasing Artefakt werden mehr als deutlich. Im laufenden Filmbild werden sie als „Kantenflimmern“ noch deutlicher, das Bild wirkt wie schlecht digitalisiert, das Limit der FullHD Auflösung wird störend.

Original (oben) & Epson SuperResolution (unten)

Gleichzeitig erkennt der Algorithmus das subtile „Ringing“ als solches nicht, sonden versucht, die Doppelkonturen ebenfalls nachzuschärfen. Dadurch wird dieses Artefakt weiter verstärkt und verleiht dem Bild noch mehr Künstlichkeit. Für Freunde eines natürlichen Bildeindrucks sind hier lediglich die ersten beiden schwächeren Stufen der Super-Resolution zu nutzen, hier wird die Schärfe effektiv betont, ohne dass an aus der Entfernung die störenden Nebenwirkungen zu sehr wahrnimmt. Die Stufen 3 bis 5 können wir nur Schärfe-Fetischisten empfehlen, denen Artefakte „egal“ sind.

Doppelkonturen, wohin das Auge blickt….

Insgesamt wird diese Bildszene überall nachgeschärft, auch an Stellen, wo es nicht sein soll: Denn die Häuser im Hintergrund sind bewusst sehr unscharf, um eine höhere Tiefenwirkung zu erzielen und den Protagonisten noch stärke in den Vordergrund zu stellen (siehe Beispiel in Kapitel1). Die von den Filmemachern beabsichtigte Bildkomposition wird beeinträchtigt.

Als zweite Szene wählen wir unseren Klassiker, den Marcusplatz aus Casino Royal. Hier kann jeder Algorithmus zeigen, wie ein ohnehin schon detailliertes Bild noch weiter aufwerten kann. Das Original zeigt feine Strukturen und diverse Details, die nur aus einem oder zwei Pixel bestehen.

In den ersten beiden Stufen gelingt der Epson Super Resolution durch Kontrastanhebung, die feinen Strukturen prägnanter herauszuarbeiten und somit die subjektive Schärfe zu erhöhen. In den Stufen 3 bis 5 überwiegen hingegen erneut die Nachteile:

Die Hauswand links ist überbelichtet und wirkt wie ausgestanzt, wie ein Relief-Filter aus Photoshop. Auch die Menschenmasse vor dem Markusdom verliert ihre Farbe und wandelt sich in weiße Flecken. Von Qualitätssteigerung kann nicht die Rede sein.

Deutlich schärfer, aber mit vielen Nebenwirkungen

Gleichzeitig wird das bei diesem Film ohnehin schon überdurchschnittlich ausgeprägte Rauschen weiter verstärkt und die Natürlichkeit weiter reduziert. Gesamtergebnis: Deutlich „schärfer“ aber sehr unnatürlich.

Anmerkung:

Alle obigen Ergebnisse beziehen sich auf die neuste Firmware-Version des Epson EH-TW9200, bei der die SuperResolution besonders stark betont wird, um dem ungeübten Auge mehr „Wow-Effekt“ zu vermitteln. Doch wir hatten auch noch einen Epson mit der älteren Firmwareversion zur Verfügung, bei dem die Super Resolution sich wesentlich feiner dosieren lässt, hier der direkte Vergleich:

Links Neue Epson Firmware, rechts alte Firmware

Wie man sieht, arbeitet die „alte“ SuperResolution subtiler und weniger augenfällig, sorgt dafür aber für einen wesentlich besseren Kompromiss aus Schärfegewinn und Natürlichkeit. Wir empfehlen daher, nicht(!) auf die neueste Firmware upzugraden.

2.2 Sonys Reality Creation

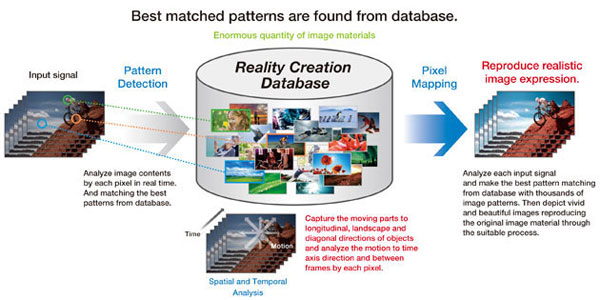

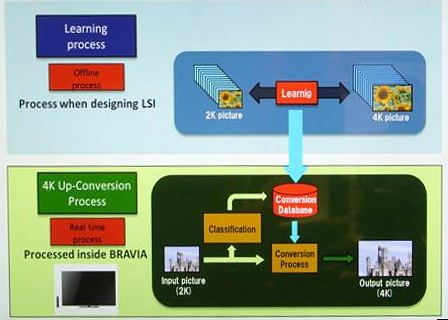

Hinter dem Sony-eigenen Marketingbegriff verbirgt sich tatsächlich auch eine Sony-eigene Technik. Sony versucht, die Arbeitsweise seines Algorithmus wie eine große „Strukturdatenbank“ dazustellen, die Details eigenständig erkennt und dann entsprechende Muster von selbst einfügt.

Doch diese Darstellung ist in die Kategorie „Marketing-Hype“ einzustufen, denn in der Praxis sind keine Tausende von Grafiken hinterlegt, wie uns Sony weismachen möchte. Dennoch ist der Algorithmus sehr komplex:

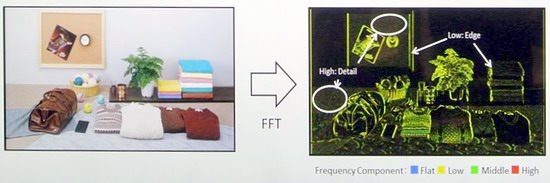

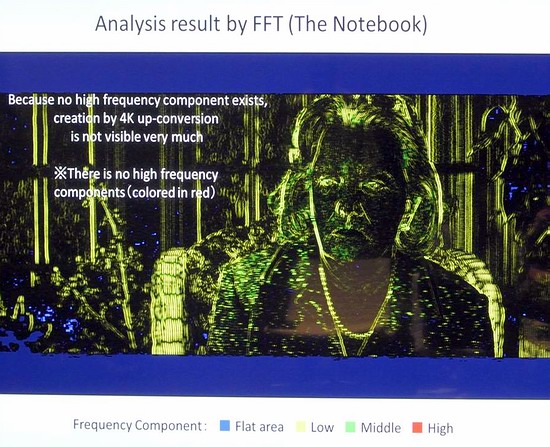

Erfahrene Heimkinoexperten wissen, dass die mathematische Fast-Fourier-Transformation ein erheblicher Bestandteil der digitalen Komprimierung in Bild und Ton darstellt und diese erst möglich macht. Im Videobereich kann sie dazu dienen, die Bildinformationen in ihre Frequenzbereiche zu konvertieren und ermöglicht so eine weitere Analyse:

Durch diese Frequenzumwandlung lassen sich z.B. die Bildpartien, die feine Details aufweisen (hohe Frequenzen) von denen unterscheiden, die nur wenig Details bieten (niedrige Frequenz). Im Beispiel oben sind diese farblich unterschiedlich markiert. Zu beachten ist, dass simple Objektkanten nicht als hoher Detailgrad eingestuft werden, sondern ausschließlich feine Strukturen.

Diese FFT- Frequenz-Analyse haben die Sony-Ingenieure für die Entwicklung ihrer Bildprozessoren mit unzähligem Bildmaterial durchgeführt und typische, sprich immer wiederkehrende, Charakteristika in einer Datenbank gesammelt. Die Datenbank ist daher nicht als simpler „Grafikspeicher“ zu verstehen, in der grafisch diverse Muster abgelegt sind, sondern vielmehr als Ansammlung mathematischer Frequenz-Konvertierungen (Konvertierungs Datenbank). Dabei hilft Sonys langjährige Erfahrung im 4K-Aufnahmebereich und des Masterings selbstverständlich.

Wie efffektiv arbeitet dieses System nun? Das hängt vornehmlich von dem Bildmaterial ab: Je „schärfer“ die FullHD (oder SD) Quelle gemastert wurde, desto mehr „Spuren“ erkennt der Reality Creation Algorithmus, desto effektiver kann er seine Algorithmen zur Auflösungsergänzung einsetzen.

Am besten kommt die Reality Creation mit FullHD Material zurecht, das aus einem 4K Master gewonnen (runterskaliert) und komprimiert wurde. Hier erkennt der Algorithmus die typischen 4K->2K Skalierungsartefakte und es kommen Bildbereiche mit hohen Frequenzen zum Vorschein.

Bei diesem Beispielbild werden alle Frequenzbereiche abgedeckt: Torschatten und die Rückseite der Tafel sind großflächig (niedrige Frequenz, blau), die Mauersteine und Wiese zeigen feinere Details (mittlere Frequenzen, gelb/grün) und die Inschriften der Grabsteine sehr feine Details (hohe Frequenz, rot). Mit anderen Worten: In diesem Beispielbild arbeitet die Reality Creation besonders effektiv im Bereich der Mauern und der Inschriften.

Doch es gibt auch FullHD-Masterings, in der die Reality Creation keine solchen Wunder bewirken kann: Dies ist meist dann der Fall, wenn der Film ursprünglich nur in 2K abgetastet wurde und feine Details in ihrer Frequenz bei der Komprimierung schon entsprechend abgeflacht wurden.

Dieses zweite Beispiel zeigt ein solches Mastering: Selbst in feinen Strukturen wie z.B. den Haaren, der Gesichtshaut oder dem Blazer wurden durch die Komprimierung bereits alle hohen Frequenzen „gefiltert“, man kann dies wie ein Bandfilter zur Erhöhung des Komprimierungseffektivität verstehen. Bei derartigem Material gelingt es der Reality Creation zwar, durch die typische „Super Resolution“ Pixelanalyse, die subjektive Schärfe zu erhöhen, doch objektiv mehr Details werden nicht geweckt.

Soweit so gut, der Algorithmus ist also in der Lage, fein aufgelöste Bildinhalte zu erkennen und evtl. weiter zu verwenden. In der eigentlichen Darstellung stellt sich aber ein Problem: Ein herkömmlicher FullHD Projektor bietet nicht viel Auflösungspielraum gegenüber der Quelle, um die erkannten Details mit Bildinformationen zu ergänzen. Der Algorithmus muss sich also darauf beschränken, Artefakte zu minimieren, entweder durch Pixelgamma oder Umrechnung.

Also alles nur Marketinghype ohne realen Nutzen? Wir schauen einfach wieder hin:

Oben Original, unten Sony Reality Creation

Auch dem Sony HW55 gelingt auf dem ersten Blick eine merkliche Steigerung der Bildschärfe. Details an Tasche und Haare werden stärker betont, wirken aber nicht zu digital. Allerdings wird der bewusst unscharfe Hintergrund hier deutlich nachgeschärft und Bildrauschen auf der Straße betont.

Auch die Reality Creation ist nicht in der Lage, das ungewollte Ringing des Originals zu erkennen und verstärkt die lästigen Doppelkonturen, so dass sie aus der Entfernung sichtbar werden, allerdings nicht auf einem so groben Niveau, wie der Epson. Aliasing und Ausfransungen werden hingegen nicht provoziert, hier ist die Reality Creation intelligenter.

Oben Orignal, unten Sonys Reality Creation

Bei der Marcusplatzszene werden Vor- und Nachteile ebenfalls deutlich: Die Bildschärfe wird signifikant gesteigert, ohne dabei ausgestanzt verfremdet wie beim Epson zu wirken. Auch die Farbgebung kleiner Details bleibt erhalten.

Oben Orignal, unten Sonys Reality Creation

Das Rauschen des Filmes wird hingegen beträchtlich verstärkt und stört deutlich den sonst guten Bildeindruck, da hilft auch der separat einstellbare Noise-Reducer der Reality Creation nicht viel. Bei all unseren Tests sollte man die Realty Creation auf keinen Wert höher 30 einstellen (die Skala geht bis 100), wenn man die Natürlichkeit bewahren möchte.

2.3 Darbee Darblet

Bei dem Darbee Darblet handelt es sich um eine kleine Box, die in das HDMI-Signal eingeschliffen wird. Mit einem Preis von ca. €250.- Euro ist sie teurer, als so mancher Bluray Player und die Erwartungen an ihre Leistung entsprechend hoch.

Gesteuert wird der Darblet über sein eigenes Menü, das sich als überraschend vielseitig erweist. Verschiedene Anwendungsprofile sind hier vorprogrammiert und können anschließend fein justiert werden. Wie bei den anderen Systemen wählten wir eine moderate Einstellung.

In unserer ersten Testszene erreicht auch der Darblet auf den ersten Blick eine erhöhte Schärfe. Bei genauer Betrachtung wird die Arbeitsweise deutlich: In feinen, hochfrequenten Details (wie z.B. den Haaren) wird das Gamma gespreizt, um den Kontrast und damit de subjektive Schärfe zu erhöhen.

Oben orginal, unten Darbee Darblet

Diese Methode wird auch in gröberen Details wie den Falten in der Tasche angewandt, so dass diese ebenfalls an Plastizität gewinnt. Das Ergebnis wirkt ansprechend, ohne dabei zu übertrieben zu sein. Die Häuser im Hintergrund werden etwas nachgeschärft, die originale Bildkomposition aber nicht zu sehr verfremdet. Auch störendes Bildrauschen wird nicht provoziert.

Besonders lobenswert arbeitet der Algorithmus bei den Kontrastübergängen an den Beinen: Sie werden weder nachgeschärft, noch wird das Ringing des Originals verstärkt. Hier findet keinerlei Nachbearbeitung statt, denn sie ist auch gar nicht notwendig.

Oben Original, unten Darbee Darblet

Gute Ergebnisse auch beim Markusplatz: Die Detailzeichnung wird erhöht, ohne dem Bild einen digitalen Look zu verleihen. Kleine Details behalten ihre Farbe. Das Rauschen wird nur minimal verstärkt und bleibt auf unscheinbarem Niveau. Allerdings ist der Schärfegewinn subjektiv nicht ganz so hoch, wie bei der Reality Creation.

3. Fazit

Drei verschiedene Systeme, drei Algorithmen, drei Bilder: Obwohl jeder Hersteller dasselbe Ergebnis verspricht und auch einhält, erzeugen alle drei Systeme einen gänzlich unterschiedlichen Look, der dem Bild wie ein eigener Fingerabdruck aufgelegt wird, mit individuellen Stärken und Schwächen. Neben obigen Beispielszenen untersuchten wir alle Systeme mit zahlreichem Bildmaterial, um einen differenzierten Eindruck zu gewinnen.

Am ausgewogensten erschien uns dabei das Bild des Darbee Darblet: Einmal (moderat) konfiguriert, erhöht er die Bildschärfe merklich und dennoch subtil genug, ohne störende Artefakte wie Doppelkonturen, Aliasing oder Rauschen überzubetonen. Auch die Bildkomposition mit etwaig gewollten Unschärfen wird in den eisten Fällen nicht zu sehr verfremdet. Trotz seines hohen Anschaffungspreises ist der kleine Bildprozessor in der Lage, das Bild von Projektoren, die ab Werk nicht mit dedizierten Schärfealgorithmen ausgestattet sind, sichtbar aufzuwerten.

Den schnellsten „Wow“-Effekt erzeugt zweifelsohne Epsons Super Resolution, denn hier wird die subjektive Schärfe auf den ersten Blick und in nahezu jeder Bildszene deutlich verstärkt. Dies weiß zunächst zu gefallen, doch bei kritischem Hinsehen fallen auch schnell diverse Artefaktverstärkungen wie Kantenflimmern, Rauschen, Dithering und Überbelichtungen sowie Farbverluste in kleinen Details auf. Wir empfehlen die Stufe „2“, die den besten Kompromiss aus Schärfegewinn und Bildtreue erreicht. Alles in allem zeigt sich, dass der SuperResolution Algorithmus in die Jahre gekommen ist und für kommende Generationen einer grundlegenden Überarbeitung bedarf.

Sonys Reality Creation liegt schließlich im Mittelfeld: Sie erzeugt eine nicht so stark betonte Schärfe, wie Epsons Variante, sorgt aber für mehr Details mit 4K-gemasterten Blurays als Darbees Darblet. Durch das starke Betonen von Bildrauschen handelt man sich hier aber auch schnell Defizite ein, die den natürlichen Bildlook trüben können. Auch hier gilt nicht selten: Weniger ist mehr!

Bleibt die Frage, wie sinnvoll alle Systeme für eine akkurate Bildreproduktion sind: Zweifelsohne sind gut gemasterte Blurays scharf genug, so dass man auf zusätzliches „Nachschärfen“ verzichten kann. Bei mittelmäßigen Übersielungen hingegen, die leider nach wie vor die große Mehrheit des Filmangebotes ausmachen, sind sie aber durchaus in der Lage, Defizite effektiv zu vermindern. Wie empfehlen einen persönlichen Vergleich bei einem unserer Heimkinopartner in ganz Deutschland.

Wir danken unseren Projektor AG Heimkino-Partnern für die Unterstützung dieses Vergleichs-Specials.

31. Januar,

Ekkehart Schmitt

Cine4Home Shopping Mall Partner,

auch in Ihrer Nähe!

Ihr

Cine4Home Team